架设GPT服务器的设置步骤是什么?

- 家电常识

- 2025-04-26

- 4

随着人工智能技术的蓬勃发展,GPT(GenerativePre-trainedTransformer)模型已经广泛应用于自然语言处理领域。在掌握如何架设GPT服务器之前,了解GPT模型的基本概念和应用场景是非常重要的。接下来,我们将详细介绍架设GPT服务器的设置步骤,确保即便是初学者也能跟随指导顺利完成搭建。

1.准备工作:硬件与软件环境要求

在开始架设GPT服务器之前,我们需要准备好硬件环境和软件环境。

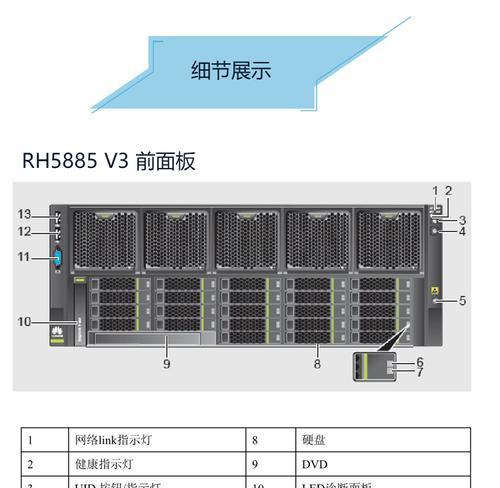

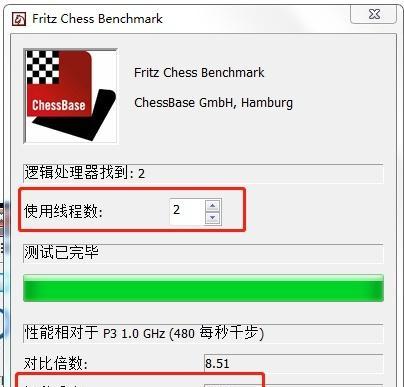

硬件环境要求

多核处理器,推荐至少16核以上。

大量的内存,推荐至少64GBRAM。

高速的SSD硬盘,以保证数据读写速度。

稳定的网络连接。

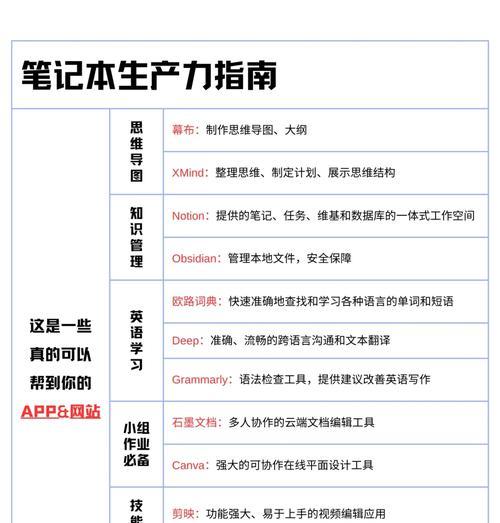

软件环境要求

操作系统:可以是Linux或Windows服务器。

Python版本:建议使用Python3.6或更高版本。

必要的依赖库,如TensorFlow、PyTorch、Transformers等。

2.安装环境:配置服务器系统

Linux系统配置

确保服务器已经安装了Linux操作系统。可以通过SSH远程登录到服务器,使用如下命令安装一些基本的依赖软件。

```bash

sudoapt-getupdate

sudoapt-getinstallbuild-essentiallibopenblas-devliblapack-devlibatlas-base-dev

```

对于Python的安装,可以使用conda来管理不同版本的Python环境。

Windows系统配置

虽然大多数服务器倾向于使用Linux,但Windows系统同样可以作为开发环境。使用Python包管理工具pip安装所需的库:

```bash

pipinstalltransformerstensorflow

```

3.配置网络环境与安全设置

为了确保服务器的安全性,需要配置防火墙规则、设置SSH密钥等。

配置防火墙,允许HTTP、HTTPS以及特定端口的访问。

通过SSH密钥认证来提升远程访问的安全性。

4.安装与配置GPT模型

接下来是安装并配置GPT模型。

安装Transformers库

利用pip安装Transformers库:

```bash

pipinstalltransformers

```

下载预训练的GPT模型

我们可以直接从HuggingFace等平台下载预训练好的GPT模型。使用以下Python代码进行下载:

```python

fromtransformersimportGPT2LMHeadModel

model=GPT2LMHeadModel.from_pretrained('gpt2')

```

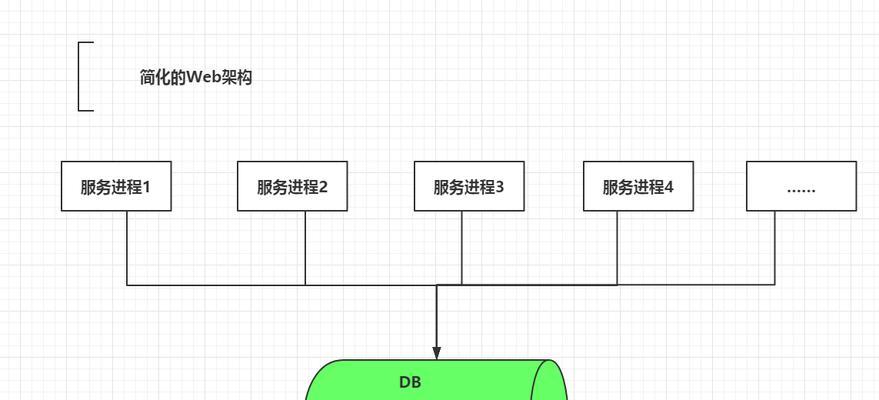

5.部署GPT服务器

使用Flask构建API接口

为了使模型能够通过网络被访问,我们使用Flask构建一个简单的API接口。

```python

fromflaskimportFlask,request,jsonify

importtransformers

app=Flask(__name__)

@app.route('/predict',methods=['POST'])

defpredict():

这里可以添加代码来调用GPT模型生成文本

pass

if__name__=='__main__':

app.run(host='0.0.0.0',port=5000)

```

部署API并进行测试

运行上述Flask应用,然后可以使用Postman等工具测试API接口是否正常工作。

6.监控与维护

服务器架设完成后,还需要进行持续的监控和维护工作,以保证服务的稳定性和可靠性。

监控工具配置

使用Nagios、Zabbix等监控工具,定期检查服务器的运行状态。

模型优化与更新

根据实际应用情况,定期更新模型和库,确保性能最优。

7.常见问题与故障排除

在架设和维护GPT服务器的过程中,可能会遇到一些常见问题,如内存溢出、模型加载失败等。在遇到问题时,应该首先查看服务器日志,并根据错误信息进行针对性的排查。

8.结语

通过以上步骤,您应该已经成功搭建了一个基础的GPT服务器。当然,这只是开始,为了将GPT模型更好地应用到实际业务中,还需要不断探索与实践,优化模型表现并开发出更加丰富的功能。随着AI技术的不断进步,架设和维护GPT服务器的技术也会不断更新。希望本文能够帮助您顺利开启自己的GPT模型之旅。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.jiezhimei.com/article-8924-1.html